PER-DDPG(Prioritized Experience Replay - Deep Deterministic Policy Gradient)を用いた狭路環境におけるロボット移動について

これは**強化学習(Reinforcement Learning: RL)の、特に深層強化学習(Deep RL)**の分野における非常に専門的で実践的な応用例です。

PER-DDPGは、狭路や障害物の多い複雑な環境での**自律移動(ナビゲーション)**において、高い効率と性能を発揮することが期待されます。

1. PER-DDPGの概要

PER-DDPGは、以下の3つの主要技術を組み合わせたアルゴリズムです。

① DDPG (Deep Deterministic Policy Gradient)

-

深層強化学習アルゴリズムの一つで、連続的な行動空間を持つ問題に適しています。ロボットの移動(例:速度、旋回角度)は連続値であるため、移動制御においてよく用いられます。

-

方策(Policy)と価値(Value)を学習する**アクター・クリティック(Actor-Critic)**構造を採用しています。

② PER (Prioritized Experience Replay)

-

学習効率を高めるための**経験再生バッファ(Experience Replay Buffer)**の改良版です。

-

単に経験をランダムに使うのではなく、学習において重要度が高い(TD誤差が大きい=予測と結果のズレが大きい)経験を優先的に再生することで、学習の収束を速め、効率を向上させます。

③ PER-DDPGとしての利点

-

DDPGは効率的な学習が難しい場合がありますが、PERを導入することで、特にまれにしか起こらない重要な経験(例:狭路をうまくすり抜けた経験、障害物に衝突しそうになった経験)を優先的に学習でき、学習の効率と安定性が大幅に向上します。

2. 狭路環境におけるロボット移動への応用

狭路環境におけるロボット移動の課題は、衝突を避けながら、効率よく、かつ滑らかに目標地点へ到達することです。PER-DDPGはこの課題に対して以下のように貢献します。

🚧 狭路環境特有の課題

-

衝突リスクの増大: 狭い通路では、わずかな制御ミスがすぐに衝突につながります。

-

行動の制約: 狭路では、ロボットが選択できる速度や旋回角度に強い制約がかかります。

-

重要な経験の稀少性: 衝突を避けるためのクリティカルな行動や、最適な経路を見つける行動は、全体の経験の中ではまれです。

🚀 PER-DDPGによる解決

-

PERによる効率的な学習: 狭い場所で**「衝突回避に成功した経験」や「衝突して大きな負の報酬を得た経験」は、通常のランダムな経験よりもTD誤差が大きくなります。PERはこの重要な経験を繰り返し学習することで、ロボットに「狭路での危険な状況」と「正しい回避行動」**を効率よく叩き込みます。

-

DDPGによる滑らかな制御: DDPGは連続的な行動を出力できるため、狭路での複雑なカーブや微細な速度調整など、滑らかで精密な移動制御を実現できます。

-

強化学習による自律性の向上: センサー情報(LiDARやカメラ)を入力として、報酬(例:目標への近接度、移動速度、衝突ペナルティ)を最大化する行動を学習するため、環境が事前に完全に分からなくても、自律的に最適な移動戦略を獲得できます。

3. システム構成のイメージ

この種のシステムは、一般的に以下のような構成で実現されます。

| 要素 | 役割 |

| 環境 | 狭路を再現したシミュレーター(Gazeboなど)または実機環境。 |

| 観測(State) | ロボット周辺の距離情報(LiDARデータ)、自己位置情報、目標地点への相対位置・角度など。 |

| 行動(Action) | ロボットの並進速度 v(m/s)と角速度 ω(rad/s)などの連続値。 |

| 報酬関数 | 目標に近づくほどプラス、衝突や低速移動でマイナスとなるように設計されます。狭路環境では、障害物との安全距離を確保するためのペナルティが特に重要です。 |

| アルゴリズム | PER-DDPGエージェントが、観測に基づいて行動を決定し、報酬から学習を行います。 |

この技術は、工場や倉庫内での無人搬送車(AGV/AMR)、あるいは災害現場などの複雑な環境での探索ロボットなどに応用が期待されます。

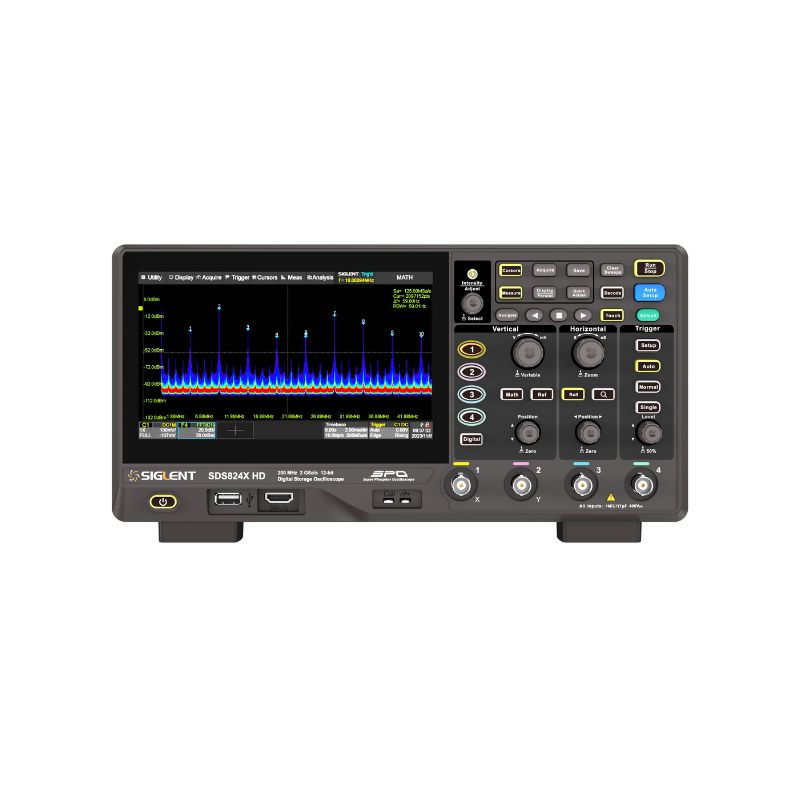

T&M

即納ストア

T&M

即納ストア